LFM2

LFM2はLiquid Foundation Modelsの新しいモデルで、デバイス上での生成AI体験を最速で提供し、前の世代に比べてトレーニング効率が3倍向上しています.

カテゴリーにリストされています:

人工知能開発オープンソース

説明

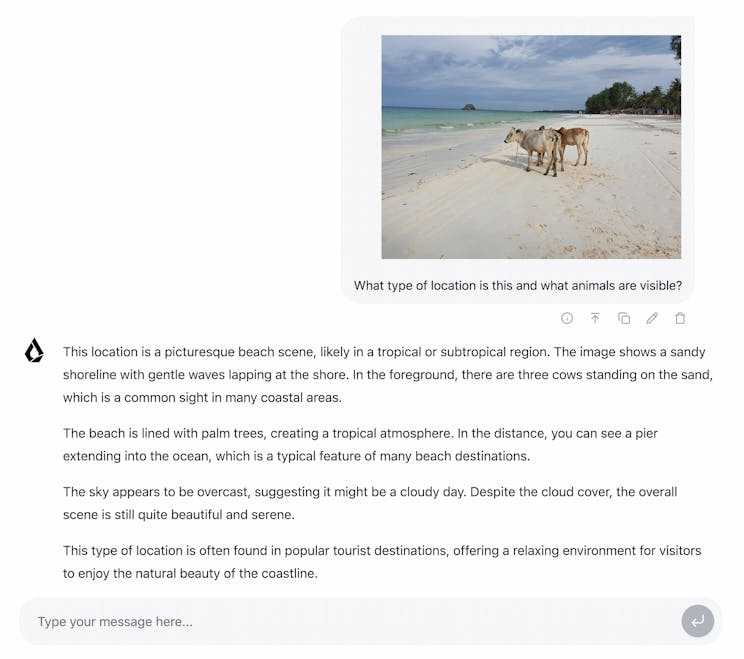

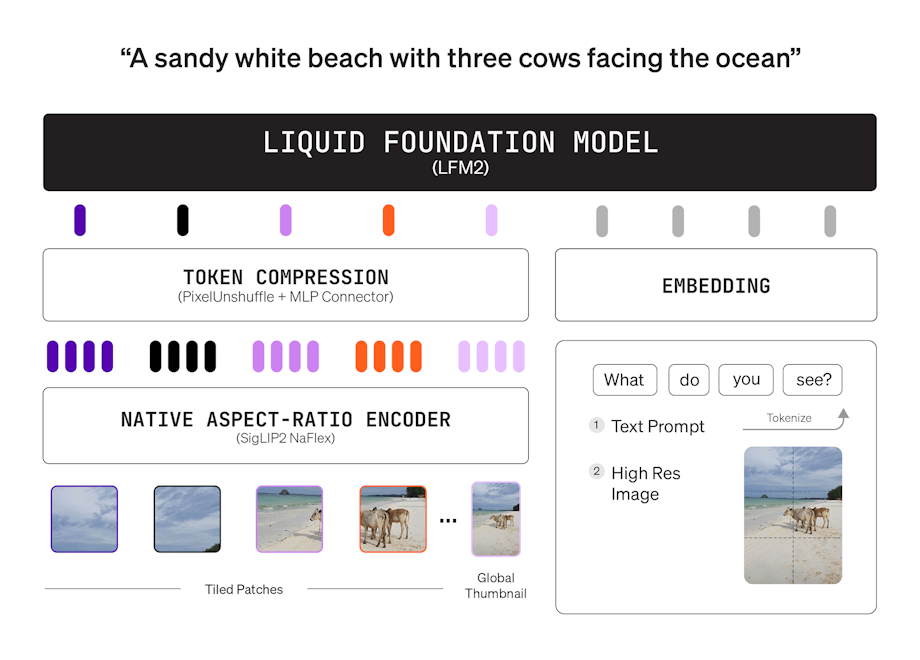

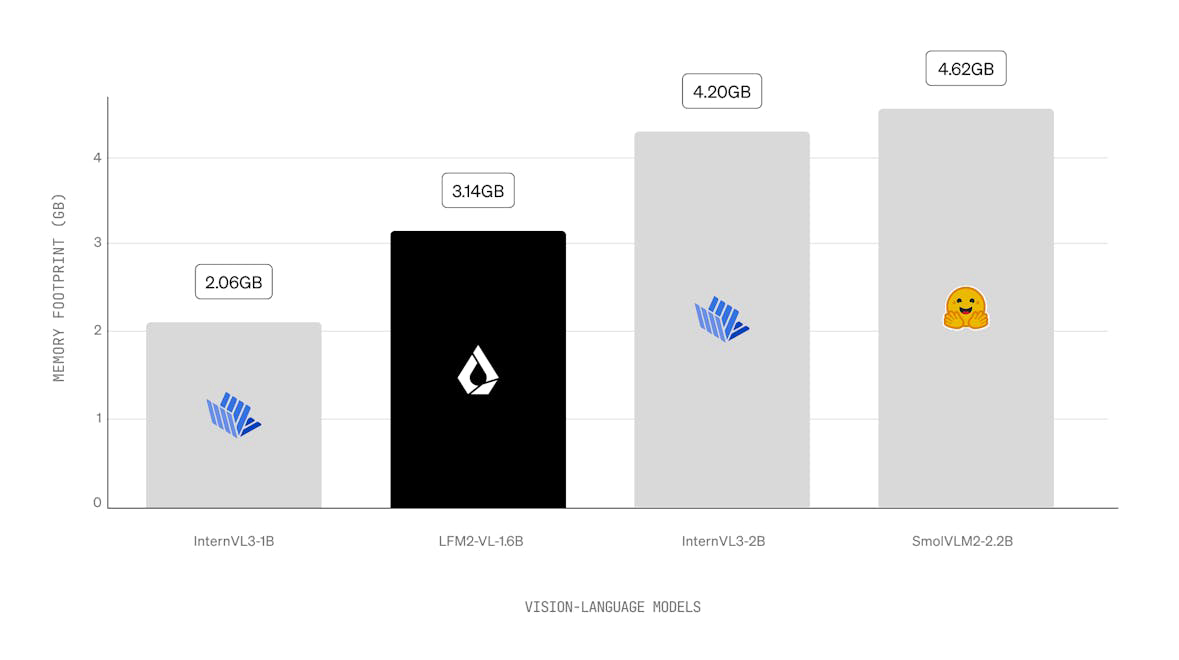

LFM2は、デバイス上での生成AIの品質、速度、メモリ効率の新しい基準を設定する新しいクラスの液体基盤モデル(LFM)です。最速のデバイス上AI体験のために設計されたLFM2は、CPU上で前のモデルであるQwen3の2倍のデコードおよびプレフィル性能を提供します。ハイブリッドアーキテクチャを採用しており、各サイズクラスのモデルを大幅に上回る性能を発揮し、ローカルおよびエッジのユースケースに最適です。LFM2は、前の世代に比べてトレーニング効率が3倍向上しており、能力のある汎用AIシステムを構築するためのコスト効果の高い道を提供します。

使い方 LFM2?

LFM2モデルは、llamacppなどの統合を使用して、デバイス上でプライベートかつローカルにテストできます。ユーザーは、特定のユースケースに合わせてモデルを微調整することもできます。カスタムソリューションについては、営業チームに連絡することをお勧めします。

の主な機能 LFM2:

1️⃣

CPU上でQwen3の2倍のデコードおよびプレフィル性能

2️⃣

前のLFM世代に比べて3倍のトレーニング効率

3️⃣

乗算ゲートと短い畳み込みを持つハイブリッドアーキテクチャ

4️⃣

CPU、GPU、NPUハードウェアでの柔軟な展開

5️⃣

スマートフォンやロボットなどのさまざまなデバイスでのリアルタイム推論に最適化。

なぜ使用するのか LFM2?

| # | ユースケース | ステータス | |

|---|---|---|---|

| # 1 | 消費者電子機器におけるローカルおよびエッジAIアプリケーション | ✅ | |

| # 2 | ロボティクスおよびスマート家電のためのリアルタイム推論 | ✅ | |

| # 3 | 金融、eコマース、教育分野での展開。 | ✅ | |

開発者 LFM2?

Liquid AI Inc.は、特定のタスクおよびハードウェア要件に対して品質、レイテンシ、メモリのバランスを取った基盤モデルの構築に専念しています。彼らは、超効率的なマルチモーダル基盤モデルを提供するためにフォーチュン500企業と連携しています。