DreamActor-M1 From ByteDance

DreamActorM1是一个基于扩散变换器的人类动画框架,采用混合指导,以实现细粒度的整体可控性、多尺度适应性和长期时间一致性。

列在类别中:

视频设计工具GitHub

描述

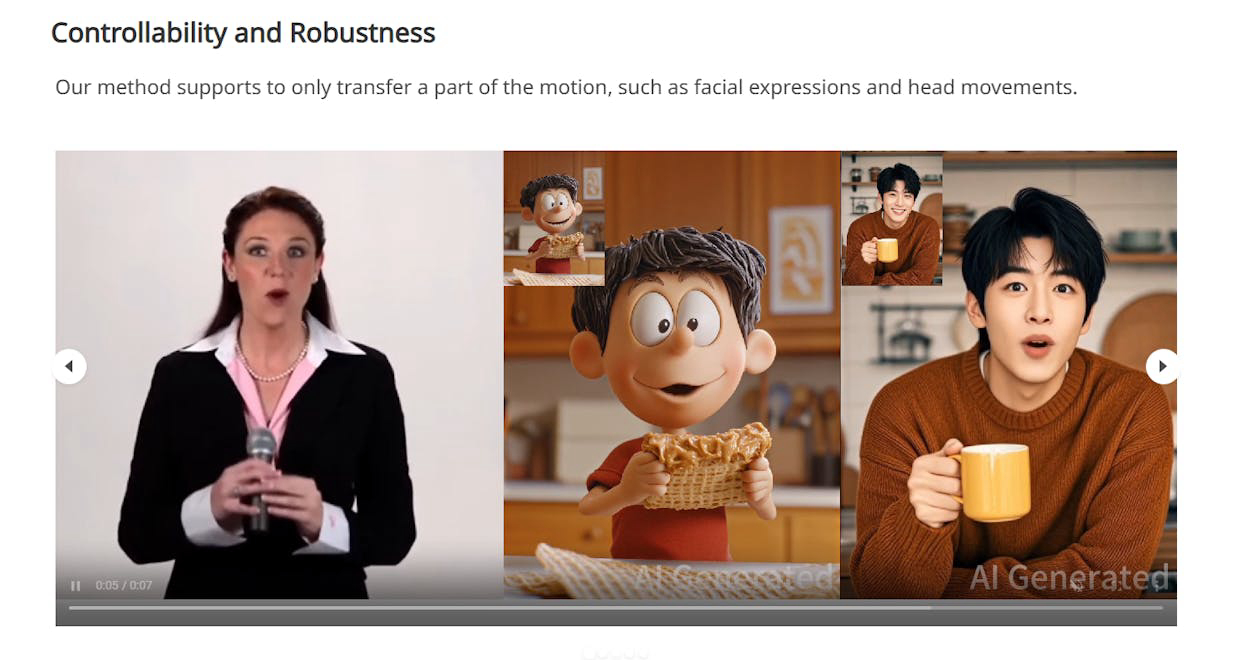

DreamActorM1是一个基于DiT的人类动画框架,利用混合指导实现细粒度的整体可控性、多尺度适应性和长期时间一致性。它可以模仿从视频中捕捉到的人类行为,生成高度表现力和逼真的人类视频,涵盖从肖像到全身动画的多个尺度。生成的视频在时间上是一致的,保持身份,并且具有高保真度。

如何使用 DreamActor-M1 From ByteDance?

要使用DreamActorM1,用户需要提供参考图像或输入视频的多个帧。该框架然后从驱动帧中提取身体骨架和头部球体,对其进行编码,并与视频潜在信息结合以生成表现力丰富的动画。用户可以通过混合指导系统控制动画的各个方面,包括面部表情和身体动作。

核心功能 DreamActor-M1 From ByteDance:

1️⃣

细粒度整体可控性

2️⃣

多尺度适应性

3️⃣

长期时间一致性

4️⃣

面部表情和身体动作的强大控制

5️⃣

支持音频驱动的面部动画和同步口型功能

为什么要使用 DreamActor-M1 From ByteDance?

| # | 使用案例 | 状态 | |

|---|---|---|---|

| # 1 | 为电影和游戏创建表现力丰富的人类动画 | ✅ | |

| # 2 | 为虚拟现实环境生成逼真的虚拟形象 | ✅ | |

| # 3 | 为社交媒体和营销制作动画内容 | ✅ | |

开发者 DreamActor-M1 From ByteDance?

DreamActorM1由一组研究人员开发,包括Yuxuan Luo、Zhengkun Rong、Lizhen Wang、Longhao Zhang、Tianshu Hu和Yongming Zhu,他们隶属于字节跳动智能创作团队。该团队在这一创新人类动画框架的开发中做出了同等贡献。